| Numéro |

Pédagogie Médicale

Volume 21, Numéro 3, 2020

|

|

|---|---|---|

| Page(s) | 143 - 157 | |

| Section | Recherche et perspectives | |

| DOI | https://doi.org/10.1051/pmed/2020041 | |

| Publié en ligne | 3 décembre 2020 | |

L’apprentissage du raisonnement clinique infirmier dans le cadre d’un dispositif éducatif numérique basé sur la concordance de scripts

Learning nursing clinical reasoning by using a digital educational setting based on script concordance

1

Faculté des sciences infirmières, Université de Montréal,

Québec, Canada

2

Centre d’innovation en formation infirmière, Université de Montréal,

Québec, Canada

* Correspondance et offprints: Marie-France DESCHÊNES, Faculté des sciences infirmières, Pavillon Marguerite-d’Youville. C.P. 6128 succ. Centre-ville, Montréal (Québec) H3C 3J7. Mailto : marie-france.deschenes@umontreal.ca.

Reçu :

1

Mai

2020

Accepté :

22

Octobre

2020

commentaires éditoriaux formulés aux auteurs le 1 octobre et le 21 octobre 2020

Contexte : Un des défis actuels des responsables de la formation des futurs infirmiers est de concevoir des stratégies éducatives pour favoriser le développement optimal du raisonnement clinique infirmier (RCI).But : L’étude visait à développer, mettre à l’essai et évaluer un dispositif éducatif numérique basé sur la concordance de scripts auprès d’étudiants en sciences infirmières. Méthodes : Un devis de recherche-développement a permis de soutenir les étapes de réalisation du dispositif éducatif. Une validation de contenu a été intégrée au devis à l’aide d’une technique Delphi modifiée. Les choix de réponses des étudiants et des experts aux questions du dispositif ont été compilés. Un questionnaire en ligne et des entrevues de groupe focalisées ont été utilisés auprès d’étudiants afin d’évaluer l’acceptabilité et l’utilisabilité du dispositif éducatif. Résultats : Cinq experts-collaborateurs ont validé le contenu du dispositif éducatif. La version finale comptait 81 questions liées à 22 vignettes. Douze experts-panélistes et quarante-cinq étudiants ont répondu aux questions du dispositif éducatif. Les indices alpha (α) de Cronbach ont oscillé entre 0,87 et 0,90. Globalement, les étudiants ont apprécié l’utilisation du dispositif éducatif, dont la rétroaction variée et formative d’experts à des situations apparentées à la vie professionnelle. Conclusion : Le dispositif éducatif repose sur l’utilisation d’un test de concordance de scripts numérisé auquel des rétroactions d’experts sont intégrées à des fins d’apprentissage du RCI. Essentiel, l’engagement des experts-panélistes inscrit la conception d’un tel dispositif éducatif dans une démarche de co-construction et de validation du matériel pédagogique.

Abstract

Context: One of the current challenges for higher education institutions is to design and implement educational strategies to promote the apprenticeship of undergraduate students’ clinical nursing reasoning. Purpose: The study aimed to develop, test and evaluate a digital educational setting based on script concordance with undergraduate nursing students. Method: Research and development study design supports the implementation of the educational setting. Content validation was incorporated into the study design using a modified Delphi technique. Students’ and experts’ answers to the educational setting have been compiled. An online questionnaire and focus group interviews were used by students to assess the acceptability and usability of the educational setting. Results: Five expert collaborators validated the content of the educational setting. The final version included 81 questions linked to 22 vignettes. Twelve expert panellists and 45 students completed the questions of the educational setting. Cronbach’s alpha (α) coefficient ranged from 0.87 to 0.90. Overall, the students appreciated the educational setting, especially the varied and formative feedback of experts to situations related to professional life. Conclusion: The educational setting is based on the use of a digital script concordance test in which expert feedback is integrated to promote learning of clinical nursing reasoning. As an essential component, the commitment of expert panellists places the design of such an educational setting in a process of co-construction and validation of teaching materials.

Mots clés : recherche-développement / raisonnement clinique infirmier / dispositif éducatif / théorie des scripts / e-Learning / formation infirmière

Key words: research and development / clinical nursing reasoning / educational setting / script theory / e-Learning / nursing education

© SIFEM, 2020

Introduction

Un des défis actuels des responsables de la formation des futurs infirmiers consiste à concevoir des stratégies éducatives pour favoriser le développement optimal des compétences visées par les programmes, parmi lesquelles le raisonnement clinique infirmier (RCI). La multiplication et la chronicisation des problèmes de santé de la population, la disponibilité variable des ressources, la globalisation des soins, les progrès technologiques et numériques sont quelques éléments qui marquent aujourd’hui la complexité de la pratique infirmière [1–3]. Cette réalité place l’infirmier nouvellement diplômé (IND) dans des situations où il devra faire preuve d’un RCI solide dès le début de sa carrière.

Contexte et problématique

Compétence au cœur de la pratique infirmière, le RCI se caractérise par les processus métacognitifs et cognitifs récursifs de l’infirmier à la présentation d’une situation clinique [4–6]. Ces processus cognitifs permettent de donner une signification aux données recueillies, de prendre des décisions cliniques et d’établir un plan de traitement adapté à la situation de santé [4–6]. Un RCI insuffisamment développé potentialise les risques d’incidents indésirables ou d’erreurs, et peut conséquemment causer des préjudices à la qualité et à la sécurité des soins [6–8].

La complexité de la pratique professionnelle, le temps et les ressources limités à l’accompagnement des IND à l’amorce de la pratique professionnelle [9] requièrent de soutenir suffisamment longtemps le développement du RCI pendant la formation, afin que les IND soient prêts à exercer la profession de façon sécuritaire. D’importants ajustements des stratégies éducatives mises en place s’avèrent nécessaires dans les programmes de formation en sciences infirmières pour favoriser le développement optimal du RCI avant le début de l’exercice de la profession [10].

De récentes recherches en formation médicale ont investigué l’apport pédagogique d’un dispositif éducatif issu des travaux sur l’utilisation des tests de concordance de scripts (TCS) [11–13]. Réalisé sur un environnement numérique, le dispositif éducatif consiste à utiliser plusieurs vignettes d’un TCS, qui présentent des contextes apparentés à la pratique professionnelle, où des données ambiguës, complexes ou incomplètes subsistent. La stratégie éducative vise à solliciter l’activation et l’utilisation des scripts, riches réseaux de connaissances élaborées et organisées dans la mémoire à long terme [14,15]. Chaque vignette présente une situation clinique ainsi que des questions liées à des hypothèses d’explications ou d’interventions, lesquelles sont accompagnées d’une nouvelle information [11–13]. Le micro jugement sollicité à chacune des questions consiste à considérer l’effet d’une nouvelle information sur l’hypothèse suggérée (Fig. 1). En d’autres mots, est-ce que la nouvelle information minimise, accrédite ou n’a pas d’effet sur l’hypothèse ?

Au cours des dernières années, le TCS a été numérisé et l’idée de la rétroaction des experts a déjà été avancée et mise en pratique en formation médicale [11–13]. Ainsi, préalablement, des experts ont eux-mêmes été exposés aux vignettes et ils ont effectué individuellement leurs choix de réponses aux questions, en les assortissant de commentaires pour les justifier [11–13]. En réalisant la stratégie éducative en ligne, l’étudiant bénéficie de rétroactions automatisées qui présentent : 1) les choix de réponses des experts ; 2) les processus variés de raisonnement clinique des experts ; 3) un message clé pour une ou un ensemble de vignettes et des ressources à consulter [16].

|

Fig. 1 Exemple d’une vignette d’un test de concordance de scripts. |

Questions de recherche et objectifs

À notre connaissance, aucune recherche n’a été réalisée pour documenter l’apprentissage du RCI d’étudiants au premier cycle universitaire en sciences infirmières en fonction de l’utilisation d’un dispositif éducatif numérique basé sur la concordance de scripts. L’étude visait à élaborer, mettre à l’essai et évaluer un tel dispositif éducatif auprès d’étudiants en sciences infirmières, afin de favoriser l’apprentissage du RCI. Les deux questions de recherche étaient : 1) Quels sont les éléments méthodologiques qui facilitent la mise en place d’un dispositif éducatif numérique basé sur la concordance de scripts ? 2) Quelles sont les perceptions d’étudiants entourant la présentation, l’utilité, la pertinence et le contenu du dispositif éducatif pour l’apprentissage du RCI ?

L’article décrit les étapes d’élaboration, de mise en œuvre et d’évaluation du dispositif éducatif.

Méthodes

Devis méthodologique

Un devis de recherche inscrit dans la perspective méthodologique de la recherche-développement en sciences de l’éducation [17] a été utilisé. Les différentes étapes d’une recherche-développement proposées par Van der Maren ont été effectuées, à savoir l’analyse des besoins éducatifs, la planification, la conception, la préparation technique, le prétest et la mise au point, ainsi que la mise à l’essai et l’évaluation du dispositif éducatif (Fig. 2).

Chacune des étapes itératives du processus de la recherche-développement a fait l’objet d’une analyse approfondie pour cibler les éléments processuels, ponctuels et contextuels qui ont façonné la conception, la mise à l’essai et l’évaluation du dispositif éducatif au sein d’un programme de formation au premier cycle universitaire en sciences infirmières. Le but était de favoriser une validité de la conception du dispositif éducatif ainsi que sa transférabilité dans d’autres contextes académiques [17].

Contexte de l’étude

L’étude a eu lieu à la Faculté des sciences infirmières de l’Université de Montréal. Cette université offre, entre autres, la formation au premier cycle universitaire donnant accès à l’exercice de la profession infirmière à plus de 200 étudiants par année. Ce programme de formation est basé sur une approche par compétences. D’une durée de trois années, le programme comprend 103 crédits, un crédit équivalant à 45 heures d’activités éducatives.

Participants

Les participants de l’étude sont des experts-collaborateurs pour valider les vignettes du dispositif, des experts-panélistes pour répondre aux questions liées aux vignettes et des étudiants au premier cycle universitaire en sciences infirmières.

Experts-collaborateurs

Cinq experts-collaborateurs ont été recrutés afin de valider le contenu et le choix des vignettes du dispositif éducatif. Ces experts-collaborateurs devaient être en contact avec les étudiants ciblés pour participer à l’étude, avoir une connaissance approfondie du « Modèle humaniste des soins infirmiers – Université de Montréal (UDM) », qui constitue le cadre de référence professionnel promu par la Faculté de sciences infirmières de l’Université de Montréal [18], et être en voie de détenir une formation de troisième cycle en sciences infirmières.

Experts-panélistes

Selon Charlin et Fernandez [19], dans un tel dispositif éducatif, le panel de référence est un groupe de personnes reconnues par leurs pairs. Ils sont en mesure de donner des réponses pertinentes aux questions, d’expliquer leurs réponses et de suggérer des pistes de réflexion. Les experts-panélistes devaient répondre aux critères de sélection suivants : 1) exercer la profession depuis au moins cinq ans en contexte de soins généraux ; 2) être reconnu comme un expert en sciences infirmières auprès des pairs et 3) avoir une connaissance approfondie du « Modèle humaniste des soins infirmiers – UDM » [18]. Un échantillonnage par choix raisonné [20,21] a permis de recruter douze experts-panélistes au sein des ressources locales (professeurs, chargés de cours, coordonnateurs de stage ou de laboratoire).

Étudiants

Des étudiants en formation au premier cycle universitaire en sciences infirmières ont été recrutés selon un échantillon de convenance [20,21]. Les étudiants de première et de troisième années ont été invités à participer à l’étude. Un maximum de 25 participants par année de formation pouvait être inscrit sur l’environnement numérique, considérant les ressources financières associées à son utilisation.

Déroulement de l’élaboration et de l’évaluation de l’intervention pédagogique

En prenant appui sur les recommandations de Van der Maren [17] pour l’élaboration d’outils pédagogiques ou de dispositifs éducatifs, l’étude s’est déroulée selon les étapes présentées sur la figure 2. La première étape, l’analyse des besoins éducatifs, a été effectuée lors de l’étude du problème et de la recension des écrits. Ces deux opérations ont permis de clarifier et de contextualiser la nécessité d’élaborer des stratégies éducatives novatrices pour soutenir l’apprentissage du RCI. Les principales activités reliées aux autres étapes de la recherche-développement sont présentées dans le tableau I.

Principales activités de la recherche-développement.

Planification

Le choix du contenu des vignettes a été fait en collaboration avec les responsables du programme de formation en sciences infirmières de l’institution d’enseignement, afin d’intégrer l’expérimentation du dispositif éducatif au contexte et au calendrier de formation des étudiants. Le choix de la plateforme a été guidé par le design du dispositif, notamment l’inscription des rétroactions numérisées d’experts-panélistes. La chercheuse a eu recours à une compagnie commerciale en matière de formation et d’évaluation en formation. Elle a reçu une formation afin d’utiliser l’environnement numérique et y déposer tout le contenu du dispositif éducatif.

Conception

La rédaction des vignettes s’est appuyée sur un outil de mesure du RCI, le TCS développé et validé dans une étude antérieure [22]. Le TCS avait démontré une bonne cohérence interne des questions (coefficient α de Cronbach = 0,86) dans l’étude initiale ainsi que dans d’autres études où il avait été traduit dans d’autres langues [23–27]. Le contenu des vignettes a été revu et adapté pour opérationnaliser le dispositif sur un environnement numérique. La rédaction de 19 nouvelles vignettes a enrichi le TCS déjà existant en passant par une mise à jour du contenu avec les composantes du « Modèle humaniste des soins infirmiers – UDM » [18]. Cette mise à jour a été effectuée pour aborder l’apprentissage du RCI dans trois champs généraux de pratique des soins infirmiers (module 1 : soins aux personnes âgées; module 2 : soins médicaux et module 3 : soins chirurgicaux). Ensuite, deux experts-collaborateurs se sont familiarisés avec les questions des vignettes et la démarche de validation en utilisant un guide descriptif conçu à cette fin. Ils ont validé la pertinence du contenu des vignettes à l’aide d’une grille d’évaluation (voir documentation supplémentaire 1). Des ajustements ont été faits à la suite de cette validation par un consensus entre la chercheuse et les experts-collaborateurs.

Les 12 experts-panélistes ont été soutenus dans leur démarche par un guide et un tutoriel en ligne conçus par la chercheuse. Ils ont répondu aux 177 questions liées aux 48 vignettes initialement rédigées et ils ont écrit des commentaires explicatifs en fonction de leurs choix de réponses pour chaque vignette (3–5 questions) d’un des trois modules. Ils devaient répondre aux questions et écrire des commentaires explicatifs courts en faisant référence à leur savoir d’expérience, sans consultation d’ouvrages de référence ou de leurs pairs. La chercheuse demeurait disponible par courriel ou par téléphone durant cette période afin de préciser les attentes. Enfin, le choix des thèmes de la synthèse éducative a été effectué par la chercheuse à partir de l’analyse du contenu des vignettes et des commentaires explicatifs des experts-panélistes (voir un exemple dans la documentation supplémentaire 2).

Préparation technique

Une version préliminaire du dispositif éducatif a été déposée sur l’environnement numérique. Elle comportait la description du dispositif éducatif, la présentation des experts-panélistes (profil professionnel avec photo), les questions liées aux vignettes des trois modules, ainsi que les trois types de rétroaction. Un guide de navigation sur l’environnement numérique a été élaboré pour les étudiants.

Prétest et mise au point

Un prétest a été effectué, en utilisant les vignettes du module de soins aux personnes âgées, auprès de quatre étudiants (septembre 2018) afin de valider la fonctionnalité du dispositif éducatif avant sa mise à l’essai. On demandait aux étudiants d’identifier des consignes à ajouter ou à ajuster, ou des modifications à apporter à l’environnement numérique pour améliorer l’expérience de formation [17]. À partir des résultats du prétest, une deuxième validation a été réalisée avec quatre experts-collaborateurs à l’aide d’une technique Delphi modifiée [28]. À la suite de ces deux opérations de validation, une mise au point de la version finale du dispositif éducatif a été effectuée par la chercheuse.

Mise à l’essai et évaluation

La mise en œuvre du dispositif éducatif a eu lieu pendant sept semaines, du 31 octobre 2018 au 18 décembre 2018. Les étudiants ont réalisé deux des trois modules (médecine et chirurgie) en mode asynchrone en dehors des heures de cours et en plusieurs séquences, selon leurs disponibilités. L’environnement numérique permettait une utilisation sur un ordinateur personnel, une tablette ou un téléphone intelligent. La chercheuse était disponible par courriel ou téléphone pour répondre aux questions. L’évaluation du dispositif éducatif incluait la compilation et l’analyse des choix de réponses des étudiants et des experts-panélistes aux 81 questions ainsi que l’évaluation de son acceptabilité et de son utilisabilité.

Collecte des données

Le tableau II présente les outils de collecte de données selon les étapes de la recherche-développement.

La chercheuse a tenu un journal de bord afin de documenter la planification, la conception et la préparation technique du dispositif éducatif. À l’étape de la conception, une grille de validation des vignettes a été ajoutée à la collecte des données. Cette grille a été utilisée pour guider la démarche de validation des experts-collaborateurs et elle a permis d’effectuer une première validation de l’ensemble des questions des vignettes. À l’étape du prétest, un guide d’entrevue semi-dirigée a été utilisé auprès d’étudiants pour sonder les fonctionnalités du dispositif éducatif. Le guide comprenait les questions suivantes : quelles sont vos perceptions par rapport au contenu, à la crédibilité des situations, au niveau de difficulté et au choix du vocabulaire ? Quelles sont vos perceptions par rapport à la structure du dispositif éducatif, soit sa présentation, la séquence des activités et sa durée ?

À la suite du prétest auprès des étudiants, la technique Delphi modifiée [28] a permis de collecter des données auprès de quatre experts-collaborateurs lors d’une deuxième validation. La démarche comprenait un questionnaire visant à choisir parmi toutes les vignettes proposées (n = 37), un lot de vignettes qui répondait au mieux aux besoins éducatifs des étudiants dans deux modules (soins en médecine et soins en chirurgie). Un seul critère de sélection guidait cette validation, à savoir le potentiel éducatif [29] de la vignette défini par sa capacité à susciter la réflexivité des étudiants. Les experts-collaborateurs ont eu un accès au dispositif en ligne pendant une période de quatre semaines du 24 septembre au 19 octobre 2018. Ils ont individuellement choisi les vignettes les plus éducatives par l’évaluation globale de chacune, incluant les choix de réponses des experts-panélistes et leurs commentaires explicatifs. Le niveau de qualité relatif quant au potentiel éducatif de la vignette était évalué en accordant une cote sur une échelle de Likert à trois niveaux de 0 à 2 (0 : tout à fait en désaccord ; 1 : ni en accord ni en désaccord ; 2 : tout à fait en accord).

Lors de la mise à l’essai, les étudiants ont expérimenté deux des trois modules du dispositif éducatif (soins en médecine et soins en chirurgie), regroupant 81 questions liées à 22 vignettes. Les choix de réponses des étudiants et des experts-panélistes à ces 81 questions ont été compilés à l’aide de tableurs Excel.

Pour évaluer l’acceptabilité et l’utilisabilité du dispositif éducatif, les étudiants ont été invités à répondre à un questionnaire en ligne et à participer à des entrevues de groupe. Le questionnaire en ligne visait à documenter les thèmes suivants : la convivialité et l’apparence générale du dispositif, la description des étapes et la clarté des instructions et du vocabulaire utilisé, le temps dédié et le nombre de vignettes, la pertinence et l’authenticité des vignettes et des hypothèses infirmières et la validité générale du dispositif éducatif pour la formation infirmière. À la suite de chacune des rubriques, les étudiants étaient invités à ajouter des commentaires.

Un guide d’entrevue semi-dirigée a été élaboré pour les rencontres en groupe. Cinq rencontres, d’une durée de 30 à 60 minutes chacune, ont eu lieu à la suite de la mise à l’essai du dispositif éducatif entre le 26 novembre et le 6 décembre 2018. Le guide d’entrevue comprenait les questions suivantes : comment a été votre expérience générale de l’utilisation du dispositif éducatif ? Quelles sont vos perceptions par rapport au contenu et à la structure du dispositif éducatif ? Quelles sont vos suggestions quant à l’utilisation du dispositif éducatif au sein d’un programme de formation au premier cycle en sciences infirmières ?

Enfin, les étudiants étaient invités à remplir un questionnaire sociodémographique après avoir terminé les deux modules. Ce questionnaire comportait des questions sur les thèmes suivants : l’âge, le sexe, l’année de formation en cours, les années d’expérience dans le domaine de la santé et des services sociaux de même que les études académiques antérieures.

Outils de collectes utilisés aux différentes étapes de l’étude.

Analyse des données

L’analyse descriptive du contenu du journal de bord a permis de décrire les facteurs contextuels, organisationnels et processuels ayant influencé le déroulement des activités de la recherche-développement. Une analyse descriptive des commentaires émis lors de la première validation des experts-collaborateurs et des commentaires émis par les étudiants lors de l’entrevue de groupe au prétest a permis d’ajuster le dispositif éducatif. À l’étape du prétest, les choix des vignettes par les experts-collaborateurs avec la technique Delphi modifiée lors de la deuxième validation ont été analysés à l’aide des indices de validité de contenu (IVC) [30]. Des IVC ont été calculés à partir du pourcentage d’experts-collaborateurs qui étaient tout à fait en accord au regard de l’apport éducatif des vignettes. Des indices de 0,75 étaient nécessaires [31] pour retenir une vignette.

Les choix de réponses aux 81 questions des vignettes ont permis de juger de la cohérence interne des questions, calculée à l’aide de l’indice alpha (α) de Cronbach. Les choix de réponses aux questions ont aussi été analysés à l’aide des calculs du niveau d’accord intra-classe par le coefficient kappa (κ) de Fleiss, Nee et Landis [32]. Le coefficient κ a permis de corréler les choix de réponses, par groupe de participants, en tenant compte de l’effet potentiel des accords obtenus par chance ou par hasard. Il varie entre 0 et 1. L’accord est d’autant plus important que le coefficient est proche de 1 [33]. Le calcul du coefficient a été basé sur un modèle mixte à deux facteurs mesurant l’accord absolu entre les participants. Le coefficient de corrélation α de Krippendorff [34] a aussi été calculé pour documenter le degré de consensus des choix de réponses. Ce coefficient a permis de prendre en compte les données manquantes. La valeur de ce coefficient varie de 0,00 à 1,00 ; une valeur α ≥ 0,80 indique un très bon degré d’accord entre les participants [34,35]. Les analyses statistiques ont été effectuées à l’aide de la version 25 du logiciel SPSS (Statistical Package for the Social Sciences) et à l’aide de tableurs Excel.

Lors de la mise à l’essai et de l’évaluation du dispositif éducatif, une compilation par fréquence des réponses a été effectuée en plus d’une analyse descriptive des commentaires écrits au sein des différentes rubriques du questionnaire en ligne. Les témoignages enregistrés lors des entrevues semi-dirigées de groupe focalisées ont été écoutés attentivement et retranscrits aux verbatim pour identifier les perceptions d’étudiants au regard des principaux éléments d’appréciation du dispositif éducatif et des ajustements suggérés. Les annotations ont été validées de façon indépendante par la chercheuse et sa directrice de recherche, deuxième auteure de cet article. Enfin, les données sociodémographiques ont été analysées à l’aide de statistiques descriptives.

Résultats

Données sociodémographiques des participants

Experts-collaborateurs

Les cinq experts collaborateurs recrutés dans l’étude étaient chargés de cours au programme de premier cycle universitaire en sciences infirmières et en voie d’obtenir un diplôme de troisième cycle en sciences infirmières.

Experts-panélistes

Les 12 experts-panélistes étaient professeurs de carrière (n = 4), chargés de cours (n = 5), responsable de l’enseignement clinique en laboratoire (n = 1), responsable du programme au premier cycle (n = 1) ou responsable des stages cliniques (n = 1). Tous étaient particulièrement intéressés au développement du RCI des étudiants en sciences infirmières. Ils détenaient une expérience générale dans les domaines des soins généraux (médecine et chirurgie) et étaient en contact fréquent avec les étudiants. Chaque expert-panéliste était présenté à la page d’accueil du dispositif sur la plateforme Web. Cette présentation incluait une brève présentation de leur profil professionnel et, avec leur consentement, leur photo.

Étudiants

Quarante-cinq étudiants ont participé à l’étude, dont 20 en première année du programme et 25 en troisième année. Le tableau III résume les données sociodémographiques.

Données sociodémographiques des étudiants participants (n = 38†).

Éléments méthodologiques liés à l’élaboration du dispositif éducatif

Deux constats ressortent des données en réponse à la première question de recherche : 1) l’expertise spécifique à l’élaboration d’un tel dispositif éducatif est nécessaire à toutes les étapes de la démarche et 2) l’approche de recherche-développement a contribué à améliorer l’élaboration du dispositif éducatif et à assurer sa validation.

L’expertise spécifique est nécessaire à l’élaboration du dispositif éducatif

Lors de la première démarche de validation, les experts-collaborateurs étaient invités à valider le contenu des vignettes à partir de l’adaptation d’un TCS existant, les commenter et les raffiner par l’ajout d’autres questions, si cela était jugé nécessaire. Les données documentées dans le journal de bord ont mis en évidence que la notion de concordance de scripts, la nature des situations et des questions dans les vignettes sont probablement au cœur des apprentissages à faire pour les experts-collaborateurs. Des questionnements pour comprendre la lecture des vignettes et la formulation des questions ont émergé pendant la démarche de validation. En plus des instructions écrites, la chercheuse a répondu de façon individuelle aux questions des experts-collaborateurs par téléphone ou par courriel. Une rencontre collective a aussi permis de discuter des interrogations suscitées par la démarche de validation. D’une durée de deux heures, cette rencontre a eu une double fonction : 1) la formation des experts-collaborateurs à la notion de concordance de scripts et 2) l’émulation collective du contenu des vignettes pour en rehausser la validité.

Dans le même ordre d’idées, un soutien a aussi été nécessaire du côté des experts-panélistes qui devaient répondre aux questions des vignettes et expliquer leurs choix de réponses afin d’offrir des rétroactions aux étudiants. Ces rétroactions constituaient une composante nouvelle à l’utilisation des questions d’un TCS. La rédaction d’un guide et la mise au point d’un tutoriel en ligne pour les experts-panélistes se sont avérées nécessaires pour les aider à répondre aux questions du TCS et à y ajouter des commentaires explicatifs. La chercheuse se rendait aussi disponible par courriel ou par téléphone afin de préciser les attentes et cinq experts-panélistes sur les 12 se sont prévalus de cette démarche. Les résultats montrent que le guide et le tutoriel ne sont pas tout à fait suffisants. La disponibilité de la personne qui entreprend ou qui coordonne un tel dispositif éducatif est aussi nécessaire pour former les experts-panélistes à la notion de concordance de scripts et ainsi, favoriser l’ajout de commentaires explicatifs pour soutenir les apprentissages des étudiants.

Ces données montraient l’expertise nécessaire de la personne qui entreprend une telle démarche pour coordonner et soutenir les activités de tous les acteurs impliqués. En bref, les résultats mettent en évidence que la démarche d’élaboration du dispositif éducatif nécessite un accompagnement intensif par une personne experte qui maîtrise bien l’approche en elle-même et qui peut guider les experts-collaborateurs et les experts-panélistes, en plus des documents d’accompagnement.

La contribution de l’approche de recherche-développement

Le devis de recherche-développement a permis de produire un dispositif éducatif empiriquement validé, visant notamment une certaine pérennité de son utilisation dans son contexte de conception. Ce devis a fourni un cadre solide et flexible pour documenter la structure et l’instrumentation rigoureuses nécessaires à l’élaboration d’un tel dispositif éducatif. À cet égard, le journal de bord rapporte plusieurs interventions de la chercheuse à chacune des étapes de l’étude pour assurer une validité de conception et des interventions qui ont été mises en place selon les besoins qui ont émergé pendant la démarche.

La rigueur imposée par le devis de recherche-développement a mené à deux consultations auprès d’experts-collaborateurs. Lors de la première démarche de validation, cette implication de deux experts-collaborateurs a permis de rehausser la qualité du contenu des vignettes rédigées. Des hypothèses d’interventions infirmières comme l’entretien motivationnel, l’approche systémique familiale et l’initiation d’examens diagnostiques ont été ajoutées dans les questions des vignettes. Une deuxième démarche de validation avec quatre experts-collaborateurs a conforté le choix d’un lot de vignettes jugées les plus éducatives parmi l’ensemble des vignettes (37) préalablement rédigées. À ce titre, 15 vignettes sur 37 ont obtenu un IVC ≥ 0,75. Ces vignettes ont été conservées pour la mise à l’essai. La chercheuse a ajouté sept vignettes qui étaient plus faiblement évaluées par les experts-collaborateurs (IVC ≥ 0,5) afin de s’assurer de la représentativité des éléments de contenu du dispositif avec les composantes du « Modèle humaniste des soins infirmiers – UDM » [18] dans les champs généraux de pratique des soins infirmiers. La version finale du dispositif éducatif incluait 22 vignettes et 81 questions.

La contribution du devis de recherche-développement a aussi permis de colliger l’information relative la mise à l’essai du dispositif éducatif en mode numérique et de conserver des traces détaillées du processus. Lors du prétest, la démarche de validation des fonctionnalités du dispositif auprès d’étudiants a permis de cibler un temps maximal de 45–60 minutes pour réaliser l’activité éducative en ligne, ce qui incluait au plus 10 à 12 vignettes. Des outils de navigation tels des liens Web supplémentaires et des captations vidéo ont été suggérés à la chercheuse lors de ce prétest pour améliorer l’expérience d’apprentissage du RCI à l’aide du dispositif. Des ajustements ont dès lors été effectués avant la mise à l’essai et l’évaluation. Lors de la mise à l’essai, les étudiants ont réalisé deux modules en mode asynchrone en dehors des heures de cours et en plusieurs séquences, selon leurs disponibilités. La durée moyenne de la formation dans le module de médecine (12 vignettes, 43 questions) a été de 59,9 minutes ±23,8. La durée moyenne de la formation dans le module chirurgie (10 vignettes, 38 questions) était de 46,2 minutes ±22,2.

À l’étape de l’évaluation du dispositif éducatif, la cohérence interne des questions liées aux vignettes a été évaluée à l’aide des choix de réponses des experts-panélistes et des étudiants. Les indices de cohérence interne α de Cronbach ont été élevés dans chacun des groupes, soit 0,874 pour les panélistes, 0,902 pour les étudiants de troisième année et 0,89 pour les étudiants de première année (Tab. IV).

L’analyse des coefficients de corrélation intra-classe a permis de quantifier le faible niveau d’accord relatif aux choix de réponses des trois groupes de participants aux 81 questions (Tab. V). Le coefficient κ était à 0,433 au sein des panélistes (intervalle de confiance [IC] : 0,347–0,531) démontrant un peu plus de réponses consensuelles aux questions que les étudiants de troisième année (κ : 0,379; IC : 0,301–0,472) et de première année (κ : 0,34; IC : 0,301–0,472). Les coefficients de corrélation α de Krippendorff [34] ont aussi été calculés. Les résultats présentés sur le tableau montrent aussi un faible niveau de corrélation entre les participants et ce, au sein des trois groupes. Les choix de réponses des experts-panélistes ont permis de situer le coefficient α à 0,396, comparativement à 0,258 chez les étudiants de première année et 0,313 chez les étudiants de troisième année.

Indices de cohérence interne (coefficient α de Cronbach) des trois groupes.

Coefficients de corrélation intra-classe des choix de réponses des trois groupes.

Perceptions des étudiants à l’égard du dispositif éducatif pour l’apprentissage du raisonnement clinique infirmier

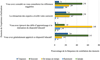

La mise à l’essai du dispositif a permis d’explorer la perception d’étudiants à l’aide d’un questionnaire en ligne et d’entrevues semi-dirigées de groupe focalisé. Trente-sept étudiants ont répondu aux questions du questionnaire en ligne (82,2%), parmi lesquels 30 étudiants ont également participé aux entrevues en groupe. Globalement, les étudiants ont apprécié l’expérience d’utilisation du dispositif éducatif, soit 85 % de souvent à toujours (Fig. 3). Les perceptions des étudiants étaient plus variables quant aux défis d’apprentissage liés à l’expérience d’utilisation du dispositif éducatif. Dix pour cent ont indiqué avoir rarement ou jamais éprouvé des défis d’apprentissage, alors que 68 % ont éprouvé des difficultés à répondre aux questions de temps en temps, 18 % souvent et 2 % ont toujours éprouvé des défis d’apprentissage. Par ailleurs, la rétroaction des experts-panélistes a souvent ou toujours éveillé la curiosité des étudiants dans 71 % des cas, alors que cela survenait de temps en temps pour 27 % d’entre eux. Vingt-six pour cent des étudiants ont consulté les références suggérées de temps en temps, 50 % souvent, alors que 8 % les ont toujours consultées. Seuls 16 % ont rarement consulté les références suggérées.

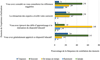

À la lecture des résultats présentés sur la figure 4, il est possible de constater que 91 % des étudiants étaient satisfaits à très satisfaits de la convivialité et de l’apparence générale du dispositif éducatif. Quatre-vingt-trois pour cent (83 %) ont témoigné de la pertinence de l’utilisation du dispositif éducatif pour la formation des infirmiers. Quatre-vingt-dix-sept pour cent (97 %) des étudiants ont jugé satisfaisante à très satisfaisante l’authenticité des vignettes. Au regard de la pertinence des vignettes et des hypothèses infirmières, 94 % étaient satisfaits à très satisfaits alors que 3 % étaient ni plus ni moins satisfaits ou insatisfaits. Le nombre de vignettes a été positivement apprécié (84 % satisfaits à très satisfaits), de même que le temps dédié à l’activité (76 % satisfaits à très satisfaits). La description des étapes d’activités en lien avec le dispositif éducatif était jugée satisfaisante à très satisfaisante pour 96 % des étudiants. La clarté des instructions et du vocabulaire utilisé est l’élément ayant reçu un niveau d’appréciation plus faible. Seuls 7 % des étudiants étaient très satisfaits, 34 % satisfaits, 29 % plus ou moins satisfaits. Trente pour cent se disaient insatisfaits à très insatisfaits.

Les commentaires émis par les étudiants pendant les entrevues de groupe ont été synthétisés et classés selon les principaux éléments d’appréciation et les éléments d’amélioration souhaités pour favoriser l’apprentissage du RCI. Ces éléments sont présentés dans le tableau VI et illustrés par quelques verbatim d’étudiants.

|

Fig. 3 Fréquence de corrélation des énoncés de l’expérience d’utilisation du dispositif éducatif. |

|

Fig. 4 Niveau de satisfaction des étudiants à l’expérience d’utilisation du dispositif éducatif. |

Principaux éléments d’appréciation et éléments d’amélioration suggérés du dispositif éducatif par les étudiants.

Discussion

Signification des résultats

L’étude visait à documenter le processus de développement d’un dispositif éducatif ainsi que les perceptions des 45 étudiants ayant participé à sa mise à l’essai. Selon les recommandations de Charlin et al. [16] et de Charlin et Fernandez [19], les experts-panélistes étaient suffisamment nombreux pour assurer une variabilité des rétroactions aux questions des vignettes. Le choix d’experts-panélistes ayant des fonctions d’enseignement rejoint les recommandations de Charlin et al. [16] et de Charlin et Fernandez [19].

La conception du dispositif éducatif a été soutenue par les étapes de la recherche-développement qui incluait un engagement des experts-collaborateurs à la validation et un accompagnement intensif de la démarche par la chercheuse. La rédaction et la conception des TCS en tant qu’outils d’évaluation ont été largement décrites dans la documentation scientifique [36–39]. La transformation de cet outil vers un dispositif éducatif suggère de nouveaux éléments à considérer pour susciter des opérations cognitives du RCI comme la génération et la confrontation d’hypothèses chez les étudiants. Une compréhension de la force associative (positive, neutre négative) entre les nouvelles informations et les hypothèses aide à saisir la subtilité rédactionnelle du contenu des vignettes. L’intention pédagogique est de favoriser la construction des scripts embryonnaires chez les étudiants. Cela requiert un temps d’appropriation de la démarche pour les concepteurs, les experts-collaborateurs et les experts-panélistes. Il est ainsi nécessaire pour tous de saisir la gymnastique mentale sous-jacente à la conception d’un tel dispositif éducatif. Tout processus de rédaction ou de validation peut ainsi être perturbé par le manque de familiarité avec la formulation des questions des vignettes qui doivent présenter des problèmes mal définis, incomplets où des éléments d’incertitude ou d’ambiguïté persistent.

Le soutien nécessaire aux experts-panélistes au regard de la rétroaction est un nouveau constat dans ce domaine de recherche. Le dispositif éducatif mise sur une triple rétroaction soutenue par l’environnement numérique. Nombreux ont été les commentaires d’étudiants entourant l’apport des rétroactions explicatives des experts-panélistes à l’apprentissage du RCI. Certains attributs, nommés par les étudiants au regard des commentaires, semblaient davantage aidants. À ce titre, la rétroaction doit être perçue en tant qu’élément fondamental dans la conception d’un dispositif éducatif et non comme un complément [40] décontextualisé ou dénué de sens par rapport aux situations présentées. Les résultats montrent qu’il semble nécessaire d’accompagner certains experts-panélistes à la lecture des questions des vignettes (par exemple, pour la présence délibérée d’éléments d’incertitude dans les questions) afin qu’ils se sentent plus à l’aise de répondre malgré les ambiguïtés ou les incomplétudes de la situation. Ils suggèrent aussi de forcer l’approfondissement de l’explicitation des experts au regard de leur processus de RCI en situation d’incertitude (par exemple, pour l’explication ciblée mais détaillée du RCI dans les commentaires justificatifs).

Le TCS, outil d’évaluation du raisonnement clinique, permet de sonder le niveau de concordance des choix de réponses d’un étudiant par rapport à ceux d’experts [38,41]. De son côté, le dispositif éducatif numérique permet de visualiser les choix de réponses d’experts et de rendre explicite leur raisonnement clinique à l’aide des explications qu’ils ont données aux questions du TCS [16]. L’étude avait pour but l’élaboration, la mise à l’essai et l’évaluation d’un dispositif éducatif numérique basé sur l’utilisation formative des questions d’un TCS. Les indices de cohérence interne α de Cronbach [42] sont élevés dans chacun des groupes, ce qui informe du niveau d’homogénéité des questions, de cohésion ou de liaison entre elles [43,44]. Il ne s’agit pas d’une estimation de la fidélité de mesure du RCI par les questions du TCS. En ce sens, les résultats témoignent d’une validité apparente du dispositif éducatif secondaire aux efforts constants de la validation des questions liées aux vignettes dans les étapes de la recherche-développement. Il est à noter que ces résultats peuvent aussi s’expliquer par la quantité importante de questions [43,45] dans l’ensemble du dispositif.

Lineberry, Hornos, Pleguezuelos et al. [46] ont exploré la validité du processus de réponses d’experts aux questions d’un TCS à l’aide d’un questionnaire en ligne. Dans un premier temps, les experts devaient juger de la pertinence des hypothèses suggérées dans les questions du TCS et expliquer leur micro jugement. Ensuite, les experts évaluaient l’effet d’une nouvelle information sur l’hypothèse suggérée dans les questions. Les experts ont répondu aux mêmes questions neuf mois plus tard. Lors de cette deuxième administration des questions, les experts ont pu consulter les explications des micro jugements d’autres experts et les références clés liées aux questions. Les résultats ont montré que des experts n’avaient pas d’emblée considéré les hypothèses proposées dans les questions, ce qui laisse présager que les scripts mobilisés chez ces experts ne seraient pas les mêmes que ceux sollicités dans les questions du TCS. Les experts indiquaient qu’ils considéraient a priori les possibilités et les contraintes de leurs milieux de pratique pour raisonner dans les situations. Certains experts modifiaient leurs choix de réponses alors qu’ils répondaient neuf mois plus tard aux mêmes questions. Ils ont expliqué que cela faisait foi de l’évolution de leur pratique clinique et de lectures professionnelles. Des experts mentionnaient qu’ils avaient pris en compte les explications des autres experts et que cela modifiait leur raisonnement actuel. En bref, ces résultats montrent que les scripts s’élaborent et se raffinent continuellement dans une perspective dynamique et développementale du raisonnement clinique. Ils informent qu’il faut aussi considérer l’élaboration du dispositif éducatif comme telle, notamment par une mise à jour fréquente des questions et une validation optimale de celles-ci. L’ajout d’autres questions (par exemple, la rationalité suivant le choix de réponse du participant) et d’outils de référencement est aussi suggéré pour enrichir l’apport pédagogique du dispositif et sonder la complexité de la compétence.

Les résultats de cette étude replacent le savoir expérientiel nécessaire à l’évaluation des données d’une situation clinique au centre du développement du RCI en contexte d’incertitude. À ce titre, la pratique professionnelle sera riche en occasions d’apprentissage tout en étant hautement individualisée par le parcours singulier de chaque infirmier. Les faibles valeurs des coefficients de corrélation intra-classe l’ont démontré. Ces résultats sont la conséquence des contenus courts, succincts et incomplets des situations dans les vignettes. Cette particularité des vignettes du dispositif s’apparente à la récurrence du doute décisionnel chez les professionnels de la santé, soit l’obligation d’effectuer fréquemment des micro jugements avec peu d’information [47]. Cela rend les choix et les interprétations très divers au sein du dispositif, mais aussi fort instructifs. Ils soulignent la nécessaire contribution et la pertinence de groupes de discussion et des outils de référencement présentés dans la troisième rétroaction numérisée. Les ambiguïtés soulevées ou les interprétations diverses méritent des échanges entre pairs et le formateur, ainsi que des consultations dans les ouvrages scientifiques pour parfaire les connaissances [16,19].

Les experts-panélistes ont été invités à expliquer leurs choix de réponses à la fin d’une vignette regroupant trois à cinq questions et non pour chacune des questions de la vignette. Cette façon de faire n’est pas d’emblée indiquée dans les écrits en éducation médicale entourant la conception d’un tel dispositif éducatif [11,12,19], où les experts-panélistes répondent à chacune des questions des vignettes. Malgré cela, cette démarche a suscité des retombées positives. Les hypothèses relatives à chacune des questions d’une vignette doivent se considérer de façon indépendante [36,38,39,41]. Toutefois, les étudiants participant à l’étude ont fréquemment indiqué avoir perçu une compréhension cumulative des données qui s’opérait inconsciemment à la lecture successive de chacune des questions d’une même vignette. Lineberry et al. [46] avaient aussi émis ce constat à l’analyse des réponses d’experts à la réalisation d’un TCS. Ces auteurs rappelaient que le raisonnement clinique implique de tenir compte de l’interaction de plusieurs données. Le fait de considérer exclusivement les informations appariées dans un TCS (hypothèse-nouvelle information) semblait induire un raisonnement limité, voire artificiel. Dans l’étude, les commentaires des experts-panélistes présentés à la fin d’une vignette ont poussé l’explication des micro jugements jugés plus essentiels ou prioritaires que d’autres. Cela a été perçu comme étant fort instructif pour les étudiants, notamment pour apprendre à prioriser ou hiérarchiser des hypothèses.

Globalement, les étudiants ont apprécié l’expérience concrète du dispositif éducatif. Les commentaires d’étudiants laissent présager qu’un nombre de 10–12 vignettes serait suffisant pour une séance en ligne d’une durée de 60–90 minutes. Ce résultat s’apparente aux recommandations de Charlin et Fernandez [19] où un nombre maximal de 20 vignettes est suggéré. Toutefois, les étudiants ont besoin d’un temps de familiarisation pour tirer un meilleur parti du dispositif éducatif. Fernandez et al. [12] et Foucault et al. [13] avaient émis le même constat dans leurs études sur l’utilisation du dispositif éducatif par des étudiants en médecine. Ces étudiants avaient été confrontés à des zones d’inconfort en l’absence de réponse consensuelle par les experts-panélistes. Dans l’étude de Foucault et al. [13], les étudiants ont admis que ce n’est qu’après avoir répondu à quelques questions qu’ils avaient compris comment l’outil fonctionnait, comme ce fut le cas dans cette étude.

Le libellé de l’échelle menant aux micro jugements a toutefois causé des inconforts chez les étudiants et a nui à l’exercice. Les étudiants se questionnaient pour savoir s’ils devaient juger la pertinence de l’hypothèse suggérée plutôt que déterminer l’effet de la nouvelle information sur l’hypothèse. Ce résultat rejoint l’expérience pédagogique décrite par Tedesco-Schneck [48] où des vignettes d’un TCS ont été utilisées et jumelées à un exercice de pensée à voix haute auprès d’étudiants en sciences infirmières. Charlin et Fernandez [19] et Charlin et al. [16] ont suggéré d’utiliser une échelle à trois niveaux (Fig. 5, exemple 1) pour activer les connaissances des étudiants débutants. Lorsque les étudiants atteignent un niveau de développement de la compétence plus élevé, cinq niveaux de réponses peuvent être envisagés afin de contextualiser l’utilisation des connaissances en zone d’incertitude (exemple 2). D’autres fois, la valeur neutre est retirée dans des situations sur le professionnalisme ou de jugement éthique pour éviter des valeurs de refuge (exemple 3).

Dans l’étude, le libellé à cinq niveaux a été utilisé auprès des étudiants de première et de troisième années. D’autres recherches pourraient mettre en lumière l’apport de cet ajustement de l’échelle menant aux micro jugements d’étudiants selon le niveau de développement de la compétence. Toutefois, un libellé tel que présenté ci-dessus (Fig. 6) pourrait diminuer les incompréhensions liées aux choix de réponses.

En plus des instructions présentées sur l’environnement numérique, un temps d’explication, en mode synchrone ou en classe, pourrait optimiser l’expérience d’apprentissage du RCI dans le cadre du dispositif. Il est ainsi recommandé d’intégrer quelques vignettes plusieurs fois dans le programme de formation. Cela aiderait les étudiants à développer la capacité d’effectuer des micro jugements en contexte d’incertitude et de s’adapter à l’absence d’une seule bonne réponse aux questions. Il est suggéré d’intégrer quelques vignettes à un cours pour aborder une notion spécifique ou encore pour élaborer une activité intégrative. Le dispositif éducatif pourrait être utilisé individuellement par l’étudiant, mais ses retombées sur l’apprentissage du RCI seraient encore plus marquées si les choix de réponses servaient de base à une discussion ou comme point de départ pour d’autres activités pédagogiques [19].

|

Fig. 5 Exemples de libellés de l’échelle. |

|

Fig. 6 Libellé des choix de réponses. |

Limites de l’étude

Dans cette étude, l’apprentissage du RCI à partir d’une présentation de vignettes repose sur des situations simulées de la pratique. Comme il s’agissait d’un apprentissage en ligne asynchrone, il est difficile d’assurer un contrôle sur les contaminations potentielles de l’apprentissage par des participants ou d’autres personnes en dehors de l’étude. Le libellé de l’échelle pour effectuer des micro jugements au sein des questions a causé des difficultés, ce qui peut occasionner des résultats basés sur une incompréhension du micro jugement à effectuer plutôt que sur les connaissances sollicitées. Bien que le dispositif éducatif ait été validé à plus d’une reprise pendant les étapes de la recherche-développement, ces démarches ont sollicité un nombre limité d’experts-collaborateurs. D’autres démarches de validation seraient nécessaires pour améliorer le contenu du dispositif, dont plus d’une ronde de validation avec une échelle adaptée [44] et un nombre plus important d’experts pour assurer sa validité [49].

Enfin, cette étude est contextualisée. Elle avait pour but d’élaborer un dispositif éducatif dans un programme de formation en sciences infirmières au sein d’une seule institution d’enseignement avec un nombre adéquat, mais limité d’étudiants. La participation à l’étude des étudiants s’inscrivait en dehors des activités déjà en place dans le cheminement académique, ce qui pouvait restreindre la disponibilité et l’intérêt de tous à participer. Il est donc envisageable que les étudiants participant à l’étude présentaient un intérêt à faire l’expérience du dispositif éducatif afin de favoriser l’apprentissage du RCI. Cela suggère d’autres mises à l’essai avec plus de participants et dans le contexte formel de cours pour généraliser les résultats et pour valider les impacts de l’utilisation du dispositif éducatif sur le développement du RCI.

Conclusion

Le dispositif éducatif numérique basé sur la concordance de scripts permet de rendre un peu plus visibles les savoirs d’experts, lesquels ne sont pas explicités dans une classe traditionnelle ou même en stage clinique. Les experts agissent comme des modèles de rôle alors qu’ils effectuent et expliquent des micro jugements effectués en contexte d’incertitude et à plusieurs reprises dans les questions du dispositif. Il s’avère intéressant, voire formateur, de noter les hésitations, les questionnements et les données éclairantes des experts qui sont des outils éducatifs précieux pour les étudiants. Cela constitue une avancée certaine de considérer l’apport des dispositifs éducatifs numériques dans les programmes au premier cycle de formation universitaire en sciences infirmières ou dans d’autres programmes de formation pour soutenir le développement du raisonnement clinique.

L’étude a permis de mettre à profit une riche documentation scientifique entourant les différentes étapes de conception, de mise à l’essai et d’évaluation d’un dispositif éducatif numérique basé sur la concordance de scripts. En amont à cette recherche-développement, l’étude a aussi permis d’explorer les stratégies cognitives d’apprentissage sollicitées chez les étudiants lors de l’utilisation du dispositif et d’examiner la génération d’hypothèses cliniques par les étudiants à l’aide des questions d’un TCS et la pensée à voix haute [50,51]. Compte tenu du temps et des ressources humaines et financières nécessaires pour développer un TCS dans un environnement numérique, l’approche éducative requiert une certaine concertation professorale pour généraliser son implantation dans les programmes de formation. À cet égard, il est suggéré de favoriser des communautés de pratique pour le partage du contenu des vignettes et d’encourager des développements techno pédagogiques pour automatiser les rétroactions aux questions du TCS sur des environnements numériques libres d’accès.

Matériel supplémentaire

Documentation supplémentaire 1. Adaptation des outils développés par Caire et al. [52] et Sibert et Fournier [39]. Grille d’évaluation pour les experts-collaborateurs.

Documentation supplémentaire 2. Rétroactions automatisées dans une vignette.

Access hereContributions

Marie-France Deschênes a contribué à la conception du protocole de recherche, au recueil des données, aux analyses statistiques, à l’interprétation des résultats, ainsi qu’à l’écriture du manuscrit. Johanne Goudreau a contribué à la conception du protocole de recherche, aux analyses statistiques, à l’interprétation des résultats, ainsi qu’à la révision et à l’approbation du manuscrit.

Déclaration d’intérêts

Les auteurs déclarent n’avoir aucun conflit d’intérêts en lien avec les résultats publiés dans ce manuscrit.

Approbation éthique

L’étude a été approuvée par le Comité d’éthique de la recherche en sciences et en santé de l’Université de Montréal au mois de décembre 2017 (17-156-CERES-D).

Financement et bourses

Le contenu du manuscrit a été élaboré dans le cadre d’une partie de la thèse doctorale de Marie-France Deschênes, qui a été soutenue financièrement par des bourses doctorales du Conseil de recherches en sciences humaines du Canada (CRSH), du Centre d’innovation en formation infirmière (CIFI) de l’Université de Montréal, de l’Équipe FUTUR, infrastructure de recherche subventionnée par le Fonds de recherche du Québec – Société et culture (FQRSC) et par la Faculté des sciences infirmières de l’Université de Montréal.

Remerciements

Les auteures remercient tous les experts-collaborateurs, les experts-panélistes et les étudiants ayant participé à l’étude ainsi que l’équipe de la compagnie THEIA, Grenoble (France) pour l’utilisation d’un espace sur l’environnement numérique.

Références

- Psiuk T. L’apprentissage du raisonnement clinique. Concepts fondamentaux – Contexte et processus d’apprentissage (2e éd.) Bruxelles : De Boeck Superieur, 2019. [Google Scholar]

- Richard L, Gendron S, Cara C. Modélisation de la pratique infirmière comme système complexe : une analyse des conceptions de théoriciennes en sciences infirmières. Aporia 2012;4:25‐39. [CrossRef] [Google Scholar]

- Pepin J, Ducharme F, Kérouac S. La pensée infirmière (4e éd.). Montréal : Chenelière Éducation, 2017. [Google Scholar]

- Simmons B. Clinical reasoning: concept analysis. J Adv Nurs 2010;66:1151‐58. [CrossRef] [PubMed] [Google Scholar]

- Goudreau J, Boyer L, Létourneau D. Clinical Nursing Reasoning in Nursing Practice: A Cognitive Learning Model based on a Think Aloud Methodology. Quality Advancement in Nursing Education – Avancées en formation infirmière 2014;1:1‐18. [Google Scholar]

- Levett-Jones T, Hoffman K, Dempsey J, Jeong S, Noble D, Norton CA, Roche J, Hickey N. The “five rights” of clinical reasoning: an educational model to enhance nursing strudent’s ability to identify and manage clinical ’at risk’ patients. Nurse Educ Today 2010;30:515‐20. [CrossRef] [PubMed] [Google Scholar]

- Thompson C, Aitken L, Doran D, Dowding D. An agenda for clinical decision making and judgement in nursing research and education. Int J Nurs Stud 2013;50:1720‐6. [CrossRef] [PubMed] [Google Scholar]

- Alfaro-LeFevre R. Critical thinking, Clinical Reasoning and Clinical Judgment: A practical approach (6e éd.). St-Louis: Elsevier, 2017. [Google Scholar]

- Charette M, Goudreau J, Bourbonnais A. Factors influencing the practice of new graduate nurses: A focused ethnography of acute care settings. J Clin Nurs 2019;28:3618‐31. [CrossRef] [Google Scholar]

- Benner P, Sutphen M, Leonard V, Day L. Educating Nurses: A Call for Radical Transformation. San Francisco (CA): Jossey-Bass, 2010. [Google Scholar]

- Lecours J, Bernier F, Friedmann D, Jobin V, Charlin B, Fernandez N. Learning-by-Concordance for Family Physicians: Revealing its Value for Continuing Professional Development in Dermatology. MedEdPublish 2018;7:1‐15. DOI: 10.15694/mep.2018.0000236.1. [CrossRef] [Google Scholar]

- Fernandez N, Foucault A, Dubé S, Robert D, Lafond C, Vincent A-M, Kassis J, Kazitani D, Charlin B. Learning-by-Concordance (LbC): introducing undergraduate students to the complexity and uncertainty of clinical practice. Can Med Educ J 2016;7:e104‐e113. [CrossRef] [PubMed] [Google Scholar]

- Foucault A, Dubé S, Fernandez N, Gagnon R, Charlin B. Learning medical professionalism with the online concordance-of-judgment learning tool (CJLT): A pilot study. Med Teach 2015;37:955‐60. [CrossRef] [Google Scholar]

- Charlin B, Tardif J, Boshuizen HPA. Scripts and medical diagnostic knowledge: Theory and applications for clinical reasoning instruction and research. Acad Med 2000;75:182‐90. [CrossRef] [PubMed] [Google Scholar]

- Schmidt HG, Norman GR, Boshuizen HPA. A cognitive perspective on medical expertise. Theory and implications. Acad Med 1990;65:611‐21. [Google Scholar]

- Charlin B, Deschênes M-F, Dumas J-P, Lecours J, Vincent A-M, Kassis J, Guertin L, Gagnon R, Robert D, Foucault A, Lubarsky S, Fernandez N. Concevoir une formation par concordance pour développer le raisonnement professionnel : quelles étapes faut-il parcourir ? Pédagogie Médicale 2018;19:143‐9. [CrossRef] [EDP Sciences] [Google Scholar]

- Van der Maren J-M. La recherche appliquée pour les professionnels : éducation, (para)médical, travail social. Bruxelles : De Boeck, 2014. [CrossRef] [Google Scholar]

- Girard F, Cara C. 2014. Modèle humaniste de soins infirmiers – UdeM. Montréal (QC) : Université de Montréal/Faculté des sciences infirmières. 2014 [On-line] Disponible sur : https://fsi.umontreal.ca/faculte/portrait-de-la-faculte/modele-humaniste-des-soins-infirmiers-udem/. [Google Scholar]

- Charlin B, Fernandez N. Préparer et animer une formation par concordance. In: T. Pelaccia (Dir.). Comment (mieux) former et évaluer les étudiants en médecine et en sciences de la santé ? Louvain-la-Neuve : De Boeck Supérieur, 2016:325‐40. [Google Scholar]

- Fortin M-F, Gagnon J. Fondements et étapes du processus de recherche. Méthodes quantitatives et qualitatives (3e éd.). Montréal : Chenelière Éducation, 2016. [Google Scholar]

- Morse JM. Strategies for sampling, in Qualitative nursing research: A comptemporary dialogue. In: Morse JM (ed). Newbury Park (CA): Sage Publications, 1990:127‐45. [Google Scholar]

- Deschênes M-F, Charlin B, Gagnon R, Goudreau J. Use of a Script Concordance Test to Assess Development of Clinical Reasoning in Nursing Students. J Nurs Educ 2011;50:381‐7. [CrossRef] [PubMed] [Google Scholar]

- Dawson TE, Comer L, Kossick MA, Neubrander J. Can script concordance testing used in nursing education to accurately assess clinical reasoning skills? J Nurs Educ 2014;53:281‐6. [CrossRef] [PubMed] [Google Scholar]

- Caboor E. Praktijkonderzoek naar het effect van ervaringsgericht leren aan de hand van een simulatie met hoge betrouwbaarheid op het klinisch redeneermogen van bachelor studenten verpleegkunde [Recherche pratique sur l’effet de l’apprentissage expérientiel au moyen d’une simulation à haute fidélité sur le raisonnement clinique des étudiants en baccalauréat en sciences infirmières]. Gent: Universiteit Gent, 2018 [On-line] Disponible sur : https://lib.ugent.be/fulltxt/RUG01/002/480/211/RUG01-002480211_2018_0001_AC.pdf. [Google Scholar]

- Menezes SS. Avaliação do Raciocínio Clínico: Adaptação e Validação do Test de Concordance de Scripts Human Caring [Évaluation du raisonnement clinique: adaptation et validation du test de concordance des scripts Human caring]. São Paulo: Universidade São Paulo, 2017 [On-line] Disponible sur : https://www.teses.usp.br/teses/disponiveis/7/7139/tde-14082017-122620/publico/SASKIA_Corrigida.pdf. [Google Scholar]

- Sadhuwong K, Koraneekij P, Natakuatoong O. Effects of a blended learning model integrating situated multimedia lessons and cognitive apprenticeship method on the clinical reasoning skills of nursing students. J Health Res 2016;30:421‐41. [Google Scholar]

- Tapaneeyakorn W, Kosolchuenvijit J, Anonrath K, Wannasuntad S, Smith P. Factors affecting clinical reasoning of nursing students at Boromarajonani College of Nursing Bangkok. J Health Sci Res 2016;10:70‐7. [Google Scholar]

- Keeney S, Hasson F, McKenna H. The Delphi technique in nursing and health research. Chichester : Wiley-Blackwell, 2011. [CrossRef] [Google Scholar]

- Norcini J, Anderson B, Bollela V, Burch V, Costa MJ, Duvivier R, Galbraith R, Hays R, Kent A, Perrott V. Criteria for good assessment: consensus statement and recommendations from the Ottawa 2010 Conference. Med Teach 2011;33:206‐14. [CrossRef] [Google Scholar]

- Lynn MR. Determination and quantification of content validity. Nurs Res 1986;35:382‐5 [PubMed] [Google Scholar]

- Polit DF, Beck CT, Owen SV. Is the CVI an acceptable indicator of content validity? Appraisal and recommendations. Res Nurs Health 2007;30:459‐67. [CrossRef] [PubMed] [Google Scholar]

- Fleiss JL, Nee JC, Landis JR. Large sample variance of kappa in the case of different sets of raters. Psychol Bull 1979;86:974‐7. [CrossRef] [Google Scholar]

- Landis JR, Koch GG. The measurement of observer agreement for categorical data. Biometrics 1977;33:159‐74. [CrossRef] [MathSciNet] [PubMed] [Google Scholar]

- Krippendorff K. Content analysis: An introduction to its methodology (2nd ed.). Thousand Oaks (CA): Sage, 2004. [Google Scholar]

- Krippendorff K. Agreement and information in the reliability of coding. Commun Methods Measures 2011;5:93‐112. [CrossRef] [Google Scholar]

- Fournier JP, Demeester A, Charlin B. Script concordance tests: guidelines for construction. BMC Med Inform Decis Mak 2008;8:8‐18. [CrossRef] [PubMed] [Google Scholar]

- Dory V, Gagnon R, Vanpee D, Charlin B. How to construct and implement script concordance tests: insights from a systematic review. Med Educ 2012;46:552‐63. [CrossRef] [PubMed] [Google Scholar]

- Lubarsky S, Dory V, Duggan P, Gagnon R, Charlin B. Script concordance testing: from theory to practice: AMEE guide no. 75. Med Teach 2013;35:184‐93. [CrossRef] [Google Scholar]

- Sibert L, Fournier J-P. ECNI - Épreuve TCS Test de concordance de script. Guide méthodologique. Paris : Les Éditions Maloine, 2015. [Google Scholar]

- Boud D, Molloy E. Rethinking models of feedback for learning: the challenge of design. Assess Eval High Educ 2013;38:698‐712. [CrossRef] [Google Scholar]

- Lubarsky S, Charlin B, Cook D, Chalk C, Van der Vleuten C. Script concordance testing: a review of published validity evidence. Med Educ 2011;45:328‐38. [CrossRef] [PubMed] [Google Scholar]

- Cronbach LJ. Essentials of Psychology Testing. New York: Harper & Row, 1990. [Google Scholar]

- Laveault D. Soixante ans de bons et mauvais usages du alpha de Cronbach. Mesure et évaluation en éducation 2012;35:1‐7. [CrossRef] [Google Scholar]

- Streiner DL, Norman GR, Cairney J. Health measurement scales: A practical guide to their development and use (5th ed.) Oxford : Oxford University Press, 2015. [Google Scholar]

- Cortina JM. What is coefficient alpha? An examination of theory and applications. J Appl Psychol 1993;78:98‐104. [CrossRef] [Google Scholar]

- Lineberry M, Hornos E, Pleguezuelos E, Mella J, Brailovsky C, Bordage G. Experts’ responses in script concordance tests: a response process validity investigation. Med Educ 2019;53:710‐22. [CrossRef] [PubMed] [Google Scholar]

- Belhomme N, Jego P, Pottier P. Gestion de l’incertitude et compétence médicale : une réflexion clinique et pédagogique. Rev Med Interne 2019;40:361‐7. [CrossRef] [PubMed] [Google Scholar]

- Tedesco-Schneck M. Use of Script Concordance Activity With the Think-Aloud Approach to Foster Clinical Reasoning in Nursing Students. Nurse Educ 2019;44:275‐7. [CrossRef] [PubMed] [Google Scholar]

- Diamond IR, Grant RC, Feldman BM, Pencharz PB, Ling SC, Moore AM, Wales PW. Defining consensus: a systematic review recommends methodologic criteria for reporting of Delphi studies. J Clin Epidemiol 2014;67:401‐9. [CrossRef] [PubMed] [Google Scholar]

- Deschênes M-F, Goudreau J, Fernandez N. Learning strategies used by undergraduate nursing students in the context of a digital educational strategy based on script concordance: A descriptive study. Nurse Educ Today 2020;95:1‐9. DOI: 10.1016/j.nedt.2020.104607. [Google Scholar]

- Deschênes M-F, Goudreau J. Study of the formulation of clinical hypotheses by nursing students through the combined use of script concordance testing (SCT) and think-aloud. Multiple case study. 2020, submitted. [Google Scholar]

- Caire F, Sol J-C, Moreau J-J, Isidori P, Charlin B. Auto-évaluation des internes en neurochirurgie par tests de concordance de script (TCS) : processus d’élaboration des tests. Neurochirurgie 2004;50:66‐72. [CrossRef] [PubMed] [Google Scholar]

Citation de l’article : Deschênes M.-F., Goudreau J. L’apprentissage du raisonnement clinique infirmier dans le cadre d’un dispositif éducatif numérique basé sur la concordance de scripts. Pédagogie Médicale 2020:21;143-157

Liste des tableaux

Coefficients de corrélation intra-classe des choix de réponses des trois groupes.

Principaux éléments d’appréciation et éléments d’amélioration suggérés du dispositif éducatif par les étudiants.

Liste des figures

|

Fig. 1 Exemple d’une vignette d’un test de concordance de scripts. |

| Dans le texte | |

|

Fig. 2 Étapes itératives de la recherche-développement. Note : Adaptation de Van der Maren [17]. |

| Dans le texte | |

|

Fig. 3 Fréquence de corrélation des énoncés de l’expérience d’utilisation du dispositif éducatif. |

| Dans le texte | |

|

Fig. 4 Niveau de satisfaction des étudiants à l’expérience d’utilisation du dispositif éducatif. |

| Dans le texte | |

|

Fig. 5 Exemples de libellés de l’échelle. |

| Dans le texte | |

|

Fig. 6 Libellé des choix de réponses. |

| Dans le texte | |

Les statistiques affichées correspondent au cumul d'une part des vues des résumés de l'article et d'autre part des vues et téléchargements de l'article plein-texte (PDF, Full-HTML, ePub... selon les formats disponibles) sur la platefome Vision4Press.

Les statistiques sont disponibles avec un délai de 48 à 96 heures et sont mises à jour quotidiennement en semaine.

Le chargement des statistiques peut être long.